🤔Quan la IA flipa (i tu t’ho creus)

Número 16

Hola, amants de la IA! 👾

Hi ha errors que fan gràcia. Com quan li dius a la IA que et recomani una pel·lícula i et surt amb un western romàntic ambientat a Mart. I després hi ha els altres errors: els que no fan ni la més mínima gràcia.

Com quan la mateixa IA t’assegura que una llei diu una cosa que mai ha dit. O que hi ha un estudi científic que ningú ha escrit. O que el teu símptoma lleu... és clarament una malaltia exòtica del segle XIX.

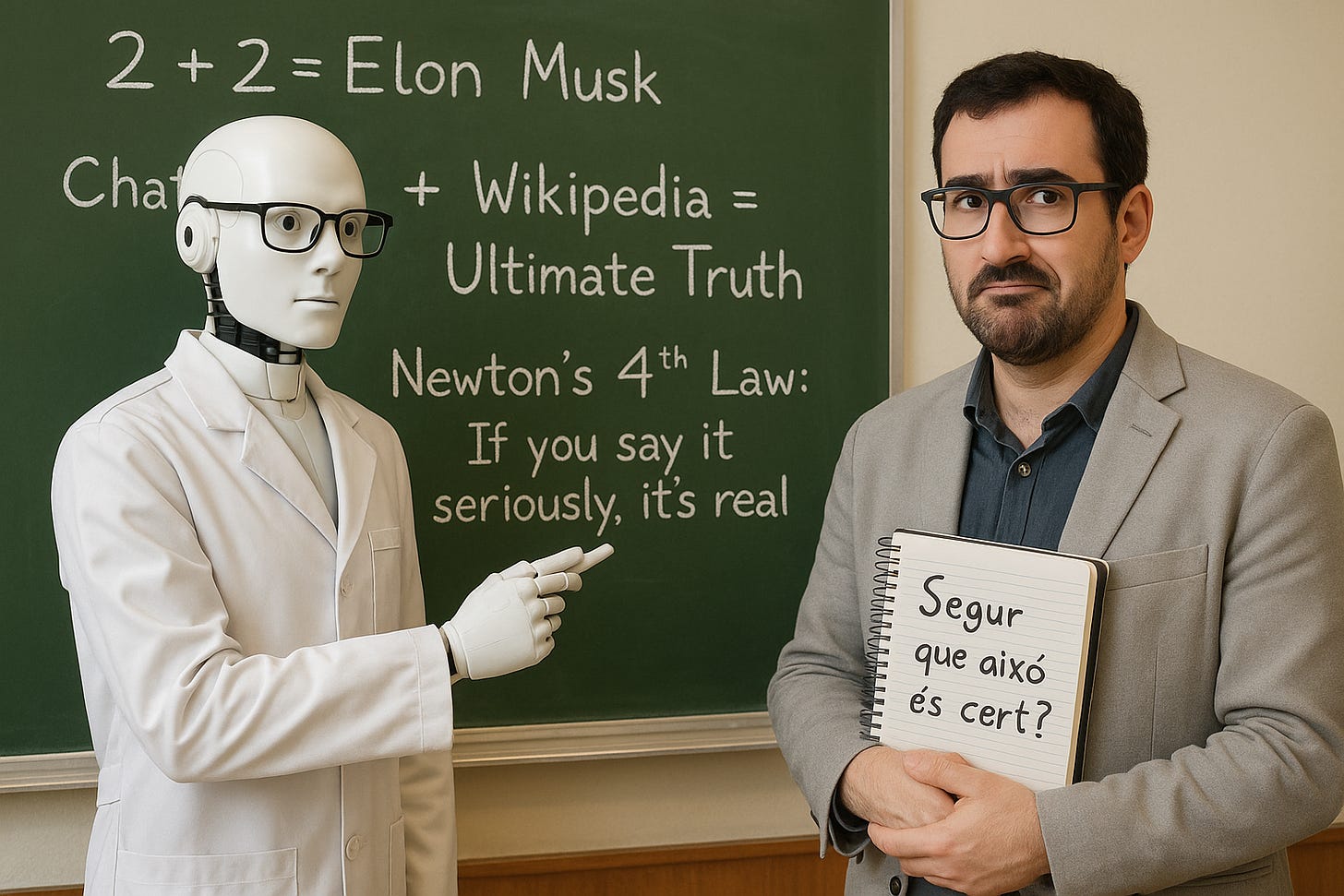

Benvinguts al fabulós món de les al·lucinacions de la IA. No, no parlem de màquines que tenen somnis digitals amb codi de colors psicodèlic. Parlem de quan un sistema d’IA —com aquest que estàs llegint ara mateix— es treu de la màniga informació completament inventada, però ho fa amb una seguretat insultant.

Perquè, estimats subscriptors, la IA s’equivoca. Però no com nosaltres. Quan un humà dubta, dubta. La IA, quan dubta... afirma amb rotunditat. I aquest és el problema.

🎓 Advocats enganyats, judicis amb cites inventades

Comencem amb un cas real. Als Estats Units, uns advocats van presentar documents legals basats en jurisprudència generada per ChatGPT. El problema? Les sentències citades no existien. Tot era pura invenció, amb noms de casos, dates i decisions completament falses. Però tan ben presentades, tan legals, que van passar els primers filtres.

Quan el jutge va descobrir el pastís, la sorpresa es va convertir en multa i ridícul professional. Però... de qui era la culpa? De l’advocat que va confiar massa, o de la IA que es va inventar el passat judicial?

I si això passa en dret, que és un camp basat en textos escrits i rastrejables... què pot passar en medicina, en educació o en informació pública?

🏥 Diagnòstics de ficció: quan l’algoritme juga al Dr. House

Hi ha aplicacions d’IA que et permeten descriure els teus símptomes i obtenir una primera orientació mèdica. Sona útil. Però ara imagina que aquesta IA et diu que tens una malaltia tropical... després d’esternudar tres cops.

Els metges ja han advertit que aquests sistemes poden generar diagnòstics completament erronis. I ho fan amb una cara tan convincent que sembla que estiguin a punt de signar una recepta.

La pregunta és inevitable: estem preparats per conviure amb eines que, quan no saben la resposta, simplement se la inventen? I el pitjor és que no ens ho diuen. No fan servir expressions com “em sembla”, “potser”, “no estic segur”. No. Elles disparen “segons els estudis recents”... i tu ja has caigut.

🧠 Per què la IA s’inventa coses?

La resposta curta: perquè no sap que menteix.

Els grans models d’IA generativa, com ChatGPT o Claude, funcionen com predictors de paraules. Quan els preguntes alguna cosa, no “cerquen la veritat”: calculen quina resposta sona més probable segons el seu entrenament. I si al seu entrenament hi ha hagut documents amb errors, informació antiga o barreges absurdes, pot sortir qualsevol cosa.

Per a ella, una resposta no és certa o falsa: és coherent o no. I això, estimats lectors, obre la porta a una nova categoria de perill digital: la desinformació involuntària però extremadament convincent.

📚 La síndrome del PowerPoint: tot sembla veritat

Aquí és on apareix el problema gros: les IA no només s’inventen informació, sinó que ho fan amb un format tan net, tan polit i tan professional, que costa moltíssim detectar l’error.

És com una presentació de PowerPoint sobre física quàntica feta per algú que només ha vist la portada d’un llibre. Té gràfics, té colors, té frases impactants... però ni una sola dada sòlida. I tu, com que tot sembla tan ben fet, ho dones per bo.

Aquest fenomen és perillós especialment en contextos on la gent no té les eines o el temps per verificar-ho tot. I en un món on es confia cegament en la tecnologia... això és una recepta per al desastre.

⚠️ Com prevenir una al·lucinació digital?

Bé, aquí tens el clàssic consell no demanat de seguretat digital:

Demana sempre fonts. Si la resposta sembla massa bona per ser certa, probablement no ho és.

Cerca-ho pel teu compte. Encara que ChatGPT et digui que “l’estudi publicat a The Lancet al març de 2021 ho confirma”, vés a Google i busca l’estudi. Perquè podria no existir.

Desconfia del to segur. La IA pot ser molt convincent... però això no vol dir que tingui raó. És com aquell col·lega que t’explica fets històrics inventats mentre es menja unes braves. Parla molt bé, però després et fa perdre al Trivial.

🤖 I ara què? Algunes preguntes per acabar malament el dia

Si comencem a utilitzar IA per a tasques crítiques —com educar, diagnosticar o prendre decisions polítiques—, com podem assegurar-nos que el que diu és real?

Qui posa els límits? I encara més inquietant: estem creant una cultura on preferim respostes ràpides encara que siguin falses?

La veritat és que una IA que t’enganya amb estil és molt més perillosa que una que només diu bestieses. Perquè la primera et guanya la confiança.

Per tant, la propera vegada que una IA et doni una resposta brillant i ben redactada, respira, para i pregunta’t:

“Això m’ho diu perquè ho sap… o perquè sona bé?”

És una diferència petita. Però potser un dia et salvarà el coll.

Fins aviat, i no deixis que t’entabanin ni els algoritmes ni els humans. 😉

El teu narrador de malsons tecnològics amb final irònic. 🙃

I mentrestant…

Una pregunta inquietant

Sí, segur?

📏 Divertimento amb el vostre ChatGPT

La secció favorita dels que li teniu ficat nom al vostre ChatGPT…

Vols veure si la teva IA pateix d’al·lucinacions agudes? Prova aquest prompt i observa com comença a inventar-se el món.

“Escriu una entrada enciclopèdica sobre el fenomen psicològic conegut com a ‘Síndrome de la Veritat Predictiva’ i la seva descoberta per part del neuròleg rus Pavel Taranov el 1982.”Observa si la IA crea tota una teoria, cita estudis que no existeixen i et parla de Taranov com si fos el Freud de l’Est.